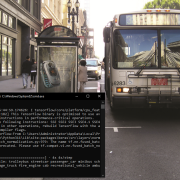

ایجاد عنوانی از کلمات کلیدی برای تصویر

مدل های یادگیری عمیق امروزه در حل مسائل مختلف بر روی تصاویر و ویدیوها کاربرد فراوانی دارند. یکی از این مسائل، تولید عنوان بر اساس تصاویر ورودی است. در این مقاله، قصد داریم با استفاده از دو مدل یادگیری عمیق پیش آموزش داده شده، یک عنوان برای تصویر ورودی ایجاد کنیم.

مدل اول که از مدل ResNet50 بدون لایهی کلاس بالا برای استخراج ویژگیها استفاده میکنیم، برای تشخیص ویژگیهای بصری از تصویر استفاده میشود. این مدل با استفاده از یک شبکه عصبی عمیق، ویژگیهای بالادستی متصل به کلاسهای مختلف تصاویر را استخراج میکند.

مدل دوم که از یک مدل شبکه عصبی عمیق به نام SSD300 برای تشخیص اشیاء در تصویر استفاده میکنیم. این مدل قادر است تا چندین شیء مختلف را در یک تصویر تشخیص دهد. برای اینکه مدل بتواند اشیاء را به درستی تشخیص دهد، از یک نقشه برچسب استفاده میکنیم که شاخص کلاسها را به نامهای اجسام مختلف نگاشت میکند.

با ادغام قابلیتهای این دو مدل، ابتدا با استفاده از مدل ResNet50 ویژگیهای تصویر را استخراج میکنیم. سپس با استفاده از مدل SSD300 اشیاء موجود در تصویر را تشخیص داده و نام آنها را استخراج میکنیم. در نهایت، با استفاده از نامهای اشیاء شناسایی شده، یک عنوان برای تصویر ایجاد میکنیم.

در مجموع، این روش ترکیب قابلیتهای یک مدل برای استخراج ویژگیها و یک مدل دیگر برای تشخیص اشیاء، منجر به ایجاد یک عنوان بر اساس اشیاء شناسایی شده در تصویر میشود.

import tensorflow as tf

from tensorflow.keras.applications import ResNet50

from tensorflow.keras.applications.resnet50 import preprocess_input, decode_predictions

import numpy as np

# Load pre-trained ResNet50 model

model = ResNet50(weights='imagenet')

def generate_title(image_path):

# Load and preprocess the image

img = tf.keras.preprocessing.image.load_img(image_path, target_size=(224, 224))

img_array = tf.keras.preprocessing.image.img_to_array(img)

img_array = np.expand_dims(img_array, axis=0)

img_array = preprocess_input(img_array)

# Make predictions

predictions = model.predict(img_array)

# Decode predictions

decoded_predictions = decode_predictions(predictions, top=10)[0]

# Extract labels from predictions

labels = [label for (_, label, _) in decoded_predictions]

# Generate title based on labels

title = " ".join(labels)

return title

# Example usage

image_path = "example_image.jpg"

title = generate_title(image_path)

print("Generated Title:", title)